Обновление: FriendlySpider 1.3

Выпущена новая усовершенствованная версия современного десктопного веб-краулера FriendlySpider 1.3, позволяющая определять фатальные SEO-проблемы сайта и подгружать обновления программы без необходимости ее повторного скачивания.

Что нового:

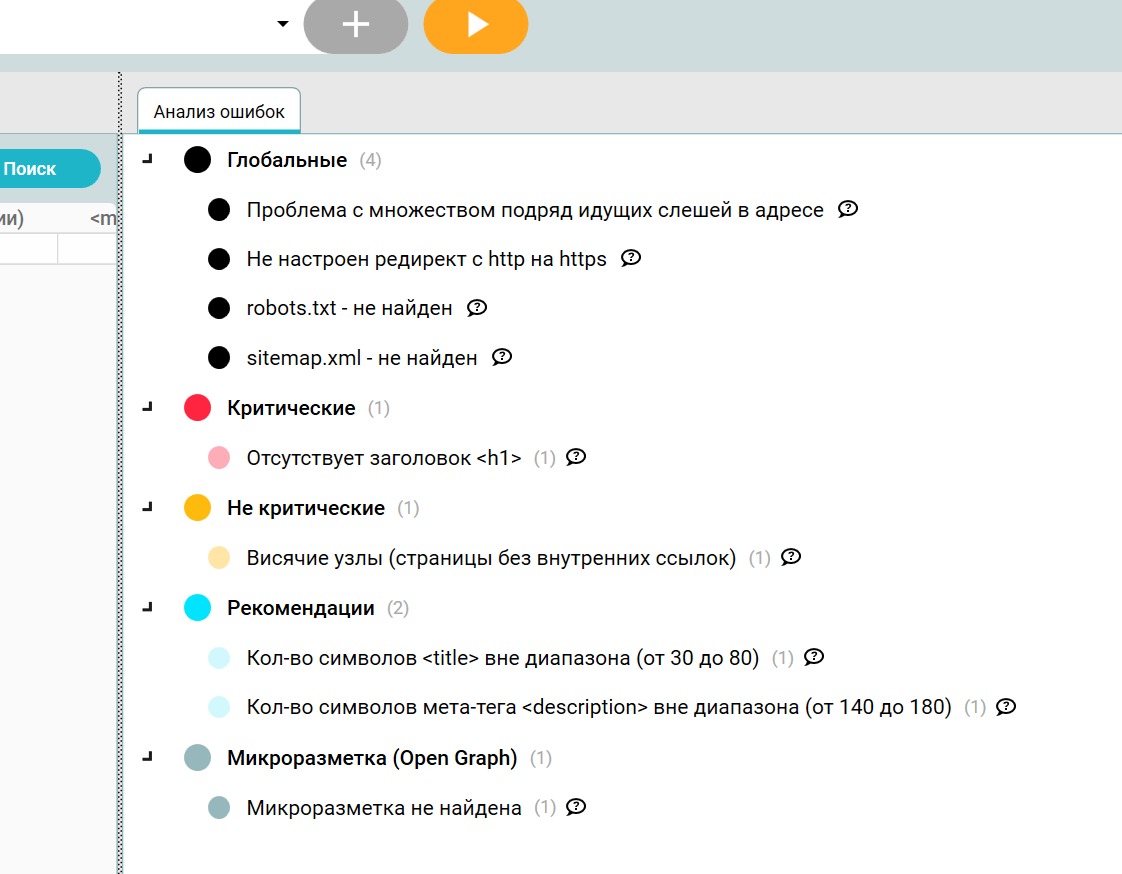

- Новый тип SEO-ошибок: «Глобальные»

Мы добавили новый тип ошибок, препятствующих успешному продвижению сайта: «Глобальные». В этом разделе мы разместили отдельные категории фатальных или наиболее грубых SEO-ошибок, касающихся всего сайта «глобально». При их наличии FriendlySpider выводит значение ошибки в отчет «Глобальные» (левая боковая панель).

Список ошибок глобального типа будет пополняться при разработке новых версий FriendlySpider. Ниже список ошибок, доступный для проверки с помощью веб-краулера FriendlySpider 1.3:

1. Зеркала сайта с www и без доступны для индексации

Сайты, доступные как с префиксом www, так и без него, воспринимаются поисковиками как два разных домена. Так, при каноническом (главном) адресе example.ru, www.example.ru является его зеркалом или полной копией. Это является грубой ошибкой, при которой два сайта с идентичным контентом конкурируют между собой в поисковой выдаче, что может повлиять на видимость обоих ресурсов. Более того, поисковые системы могут при индексации ошибиться в выборе главного ресурса, а это может комплексно влиять на продвижение сайта. Рекомендуется устанавливать 301-редиректы для склейки зеркал сайта.

2. Множественные слэши в URL-адресе

Наличие множественных слэшей в URL-адресах сайта (например, example.ru//) является грубой ошибкой, так как такие адреса формируют 100%-ные дубли страниц. FriendlySpider проверяет наличие и доступность URL-адресов сайта с множеством слэшей для поисковых роботов и выводит ошибку в боковую панель с отчетом, но только если таковая присутствует.

3. Не настроен редирект с http на https

Https-протокол обеспечивает безопасное соединение. Отсутствие перманентного редиректа с http на https является технической ошибкой, формирующей дубли, зеркала сайта.

4. robots.txt - не найден

Файл robots.txt - один из основных инструментов SEO-специалиста, указывающий роботам правила индексации сайта. Если файл robots.txt отстутствует FriendlySpider сообщит об этом по завершении проверки.

5. sitemap.xml - не найден

FriendlySpider теперь сигнализирует об отсутствии файла карты сайта.

- Автообновление

Версия FriendlySpider 1.3 содержит функционал проверки текущей версии и ее автообновления до наиболее свежей при запуске программы. Теперь вы можете не отлеживать обновления самостоятельно, вновь скачивать программу. Обновление до последней версии происходит автоматически.

- Скорректировано значение ошибки «Большое время ответа сервера»

Увеличили диапазон до 1000 мс.